1. はじめに

2025 年春の現在、生成 AI は GPT-4.1、Claude 3 Opus、Gemini 1.5 Pro、Llama 3 70B、Mistral Large など多彩なモデル が続々登場し、性能・価格・使いやすさのバランスが一段と洗練されてきました。本記事では 主要モデルの最新ベンチマーク結果と実務で役立つ使い方 をコンパクトに整理します。

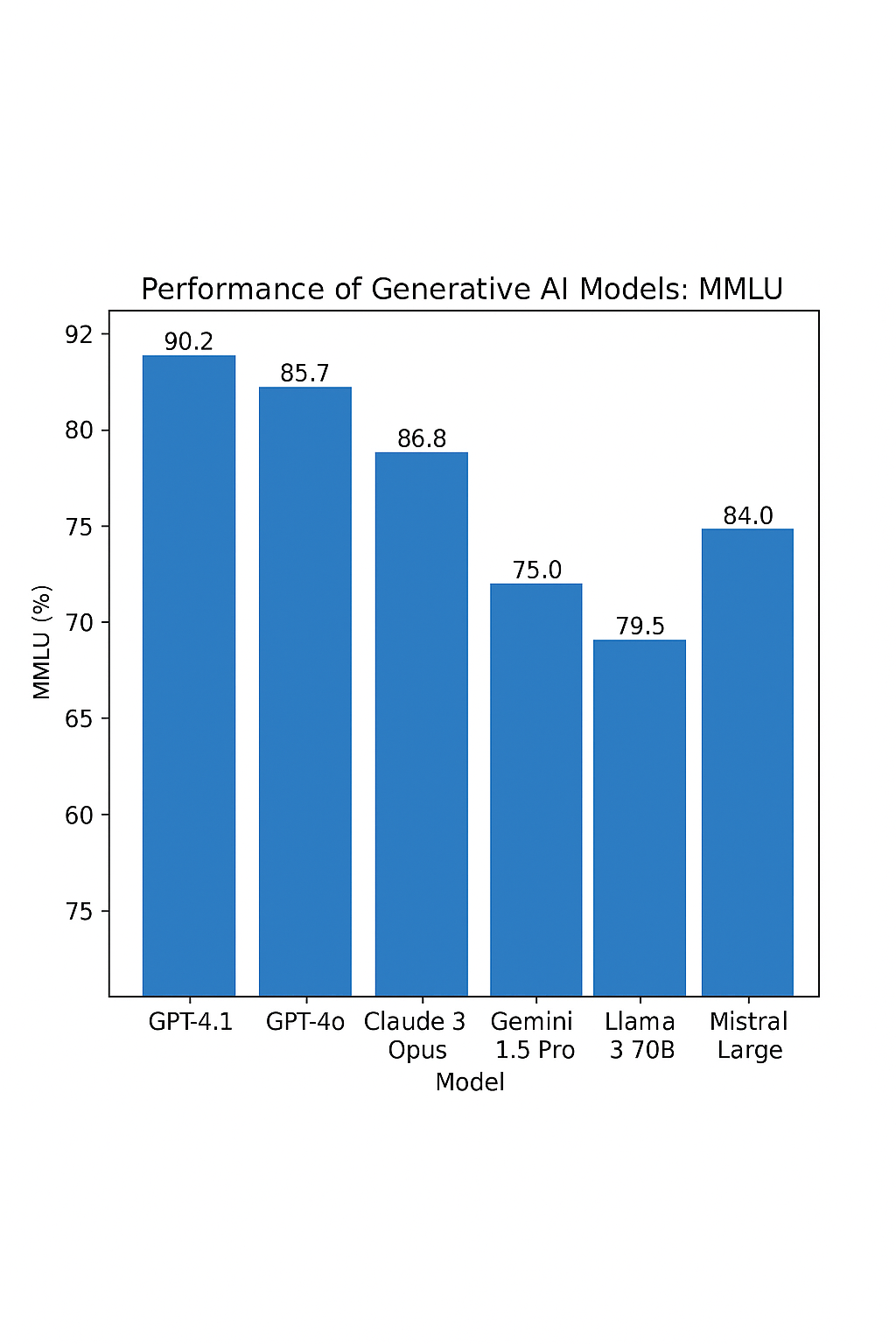

2. ベンチマークが示すもの

モデルの「頭の良さ」を測る指標は複数ありますが、学術・一般知識 57 科目を横断評価する MMLU(Massive Multitask Language Understanding)が依然 “共通テスト” 的に重宝されています。

上の棒グラフは各モデルの MMLU 正答率 を比較したものです(2025 年 4 月時点の公開値を 5-shot/1-shot換算で統一)。

| モデル | MMLU (%) | 主な特徴 |

|---|---|---|

| GPT-4.1 | 90.2 | 100 万トークン文脈、価格も GPT-4o 比 20%↓ |

| GPT-4o | 85.7 | 音声・画像も即時応答、安定の万能型 |

| Claude 3 Opus | 86.8 | 長文読解・多言語に強く企業導入拡大 |

| Mistral Large | 84.0 | オープン API 勢で最高水準、費用対効果◎ |

| Llama 3 70B | 79.5 | メタ公開の無料モデル、セルフホスティング向け (Stanford CRFM) |

| Gemini 1.5 Pro | 75.0 | 200 万トークン長文が武器、コスト低 |

3. 性能以外の比較ポイント

| 観点 | GPT-4.1 | Claude 3 Opus | Gemini 1.5 Pro | Mistral Large | Llama 3 70B |

|---|---|---|---|---|---|

| 最大文脈長 | 1 M | 200 k (要申請で 1 M) | 2 M | 32 k | 128 k |

| API 価格 (出力/1M token) | $8 | $75 | $5 | $8 | 無料 † |

| モダリティ | 文字・画像・音声 | 文字・画像 | 文字 | 文字 | 文字 |

| ライセンス | クローズド | クローズド | クローズド | クローズド (API) | オープンウェイト |

†セルフホスト時はインフラ費用のみ。

4. 便利な使い方ベスト 5

| シーン | 最適モデル | 理由 |

|---|---|---|

| ① 社内チャットボット | Claude 3 Opus or GPT-4.1 | 引用付き回答と高精度 RAG |

| ② 仕様書 → コード自動生成 | GPT-4.1 / GPT-4o | HumanEval/ SWE-Bench の高スコアで実装力◎ |

| ③ 大量 PDF 要約 | Gemini 1.5 Pro | 200 万トークン一括入力で前処理不要 |

| ④ 自社クラウドホスト | Mistral Large / Llama 3 70B | 重い GPU1 台で運用可・コスト低減 |

| ⑤ 多言語 Q&A | Claude 3 Opus | 多言語 MMLU と長文読解に強い |

5. モデル選定 3 ステップ

- 業務要件を定義 ― 精度重視か、コスト・速度・オンプレ要件か。

- PoC ベンチを自作 ― 自社データで RAG/コード生成/チャットを試験し、社内 KPI に直結した指標で比較。

- ガバナンス & サービスレベル ― 機密保持契約やリージョン、障害時 SLA を確認。API 型なら複数ベンダー冗長化も有効。

6. まとめ

- GPT-4.1 が依然トップスコアだが、Claude 3 Opus や Mistral Large も実運用で十分戦力。

- 超長文処理は Gemini 1.5 Pro が独走、自社ホストは Llama 3 70B が有力。

- 目的別にモデルを “使い分ける発想” が、2025 年の生成 AI 活用を加速させます。